Flickr 이미지 데이터셋 설명

▶ Flickr8k 데이터셋 설명 및 다운로드 방법

Flickr 데이터셋은 한 장의 이미지가 있을 때, 그 이미지를 설명하는 문장을 함께 가지고 있는 문장 단위 이미지 설명(sentence-based image description) 데이터셋의 대표적인 예시이다. Flickr 데이터셋은 Flickr30k와 Flickr8k가 있는데, 이 중에서 Flickr8k는 약 8,000장의 이미지만 가지고 있다. Flickr8k에 포함된 이미지 각각은 5개의 캡션(Caption) 정보를 가지고 있다.

예를 들어 다음의 이미지는 Flickr8k 학습 데이터셋의 이미지 중 하나이다.

위 이미지의 캡션은 다음과 같이 기록되어 있다.

① A child in a pink dress is climbing up a set of stairs in an entry way .

② A girl going into a wooden building .

③ A little girl climbing into a wooden playhouse .

④ A little girl climbing the stairs to her playhouse .

⑤ A little girl in a pink dress going into a wooden cabin .

위 캡션은 모두 정확한 표현을 담고 있다. 각 단어가 띄어쓰기로 구분되어 있기 때문에 마지막에 있는 마침표(.)가 조금 어색해 보일 수 있지만, 자연어 처리 과정에서 각 문장을 토큰으로 편하게 구분할 수 있도록 데이터셋을 구성한 것으로 보인다. 이러한 데이터셋은 Neural Image Captioning(NIC) 논문에서 주로 등장한다.

이 데이터셋은 캐글(Kaggle)에 업로드된 공개 데이터셋 링크를 통해 받을 수 있다.

▶ 데이터셋 링크: www.kaggle.com/kunalgupta2616/flickr-8k-images-with-captions

Flickr 8K Images with Captions

8000 Images with 5 captions each

www.kaggle.com

캐글(Kaggle) 로그인 이후에 [Download] 버튼을 눌러 바로 다운로드를 진행할 수 있다.

▶ Neural Image Captioning (NIC)

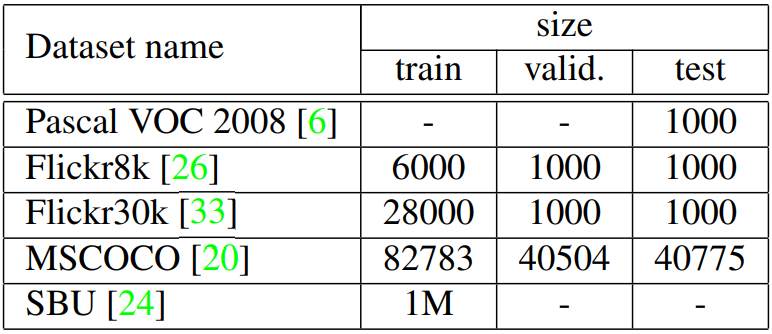

NIC는 뉴럴 네트워크를 이용해 이미지에 캡션을 붙이는 작업을 의미한다. 이 분야의 베이스라인 모델로 등장하는 네트워크는 2015년 CVPR에 등재되었던 "Show and Tell: A Neural Image Caption Generator" 논문이다. 이름부터 굉장히 심플하다. 말 그대로 한 장의 이미지를 보고, 이 이미지를 설명하는 모델을 만들어 보자는 아이디어다. 실제로 본 논문의 데이터셋을 확인해 보면 다음과 같이 Flickr8k 데이터셋을 이용한 것을 알 수 있다.

모델의 아키텍처는 굉장히 직관적이다. 사전 학습된 CNN 네트워크를 이용해 먼저 특징 벡터(feature vector)를 뽑은 뒤에, 이를 Seq2Seq 구조의 RNN 모델에 넣어 결과 문장을 뽑아낸다. 사실 아키텍처 자체는 기계 번역(machine tranlsation)에서 사용되는 아키텍처와 매우 유사한 것을 알 수 있다.

'기타' 카테고리의 다른 글

| [PyTorch 오류 해결] RuntimeError: CUDA error: device-side assert triggered (2) | 2020.11.30 |

|---|---|

| 홈택스(Hometax)에서 간단히 연소득 확인하는 방법 (소득금액증명) (0) | 2020.11.27 |

| 리눅스 소프트 링크(Soft Link) 및 하드 링크(Hard Link) 개념 설명 및 실습 (0) | 2020.11.23 |

| Ubuntu 사용자(User) 계정 추가 및 Sudo 권한 주기 / 제거 방법 (0) | 2020.11.21 |

| 깃허브(GitHub)에 새로운 이메일 추가하는 방법 (여러 개 이메일 적용) (0) | 2020.11.21 |